Best Practices für Datenmodellierung: So wählen Sie die richtige Technik für Ihr Data Warehouse

Die Auswahl der richtigen Datenmodellierungstechnik und des passenden Datenmodells ist entscheidend für den Erfolg Ihres Data Warehouses. Da es eine Vielzahl unterschiedlicher Ansätze gibt, kann es herausfordernd sein zu bestimmen, welcher Ansatz die Anforderungen Ihres Unternehmens am besten erfüllt. In diesem Beitrag stellen wir Ihnen wichtige Best Practices für die Auswahl der geeigneten Datenmodellierungstechnik vor.

Verstehen Sie Ihre Geschäftsanforderungen

Der erste Schritt bei der Wahl einer Datenmodellierungstechnik besteht darin, die geschäftlichen Anforderungen zu identifizieren, die das spätere Datenmodell beeinflussen. Dazu zählen komplexe Analyse- und Reportinganforderungen des Managements sowie moderne Analysekonzepte, die Berater im Zuge eines Projekts empfehlen. Auch Frontend-Tools bringen eigene Analysemodelle mit, die jedoch passende Datensätze benötigen – häufig nur durch ein Data Warehouse oder Data Lakehouse realisierbar. Sobald alle Anforderungen definiert sind, können Sie ein Modellierungsverfahren auswählen, das echten Mehrwert bietet.

Bewerten Sie Ihre Datenquellen

Für die Auswahl des richtigen Datenmodells ist ein tiefes Verständnis der vorhandenen Datenquellen entscheidend. Dazu gehören Qualität, Struktur und Komplexität der Daten. Durch diese Analyse lässt sich eine Technik wählen, die optimal zu den individuellen Datenanforderungen Ihres Unternehmens passt.

Auswahl der Werkzeuge

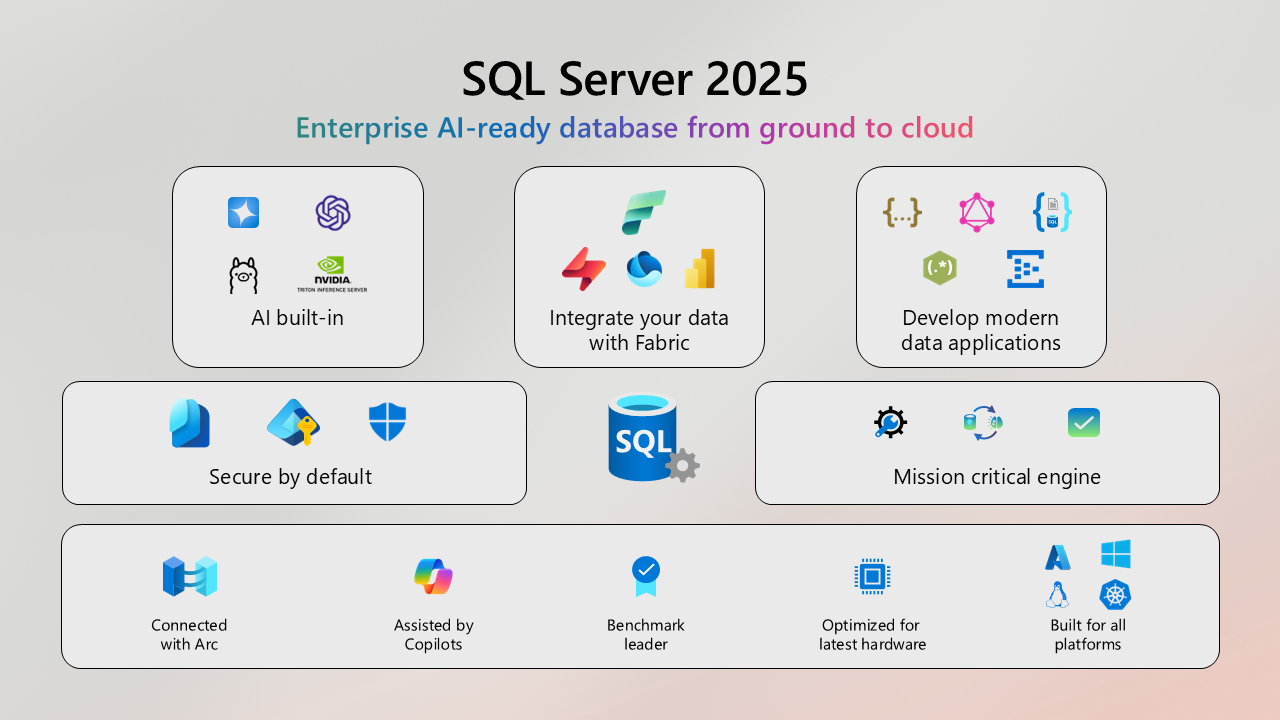

Hierzu zählen die Datenbanktechnologie, die Analytics-Plattform sowie die Frontend-Technologie. Die Tools müssen Ihre Quelldaten effizient verarbeiten, ein Data Warehouse schnell aufbauen können und die gewünschte Modellierungstechnik unterstützen. Ebenso wichtig ist, dass Ihre Mitarbeitenden über die notwendigen Fähigkeiten verfügen, die gewählten Werkzeuge anzuwenden.

Berücksichtigen Sie Skalierbarkeit und Leistung

Wählen Sie eine Modellierungstechnik, die sowohl mit wachsenden Datenmengen umgehen kann als auch flexibel genug ist, um Datenquellenänderungen zu berücksichtigen. Eine ideale Technik ermöglicht schnelle Abfragen, erleichtert die Integration neuer Datenquellen und bleibt auch bei komplexen, heterogenen Systemlandschaften performant.

Identifizieren Sie Integrationsanforderungen

Eine gute Datenintegrationsstrategie beeinflusst sowohl die Wahl der Datenhaltung als auch das Datenmodell selbst. Die Modellierungstechnik sollte Historisierungskonzepte sowie Change Data Capture (CDC) unterstützen. Ebenso müssen Anforderungen der BI-Tools berücksichtigt werden, um einen durchgängigen Datenfluss sicherzustellen.

Wählen Sie eine Modellierungstechnik, die zu Ihren Daten passt

Daten unterscheiden sich stark in Struktur und Eigenschaften. Deshalb sollte die Modellierungsmethode optimal zu Ihren Datentypen passen. Bei unstrukturierten Daten ist es wichtig, passende Verfahren oder Tools zu identifizieren, um diese zuverlässig in strukturierte Formen zu überführen.

Berücksichtigen Sie Menschen und Fähigkeiten

Bewerten Sie die vorhandenen Kompetenzen in den Bereichen Datenanalyse, Datenmanagement, Datenbankadministration und Datenintegration. Nur wenn Fähigkeiten, Branchenwissen und technische Expertise im Team vorhanden sind, kann eine Modellierungstechnik erfolgreich umgesetzt werden. Ebenso müssen Ressourcen für Wartung und Weiterentwicklung verfügbar sein.

Berücksichtigen Sie Maintenance und Support

Die Pflege eines Data Warehouses kann kostenintensiv sein. Daher sollten Kosten für Entwicklung, Wartung und Lizenzen ebenso berücksichtigt werden wie der Support des Herstellers oder der Open-Source-Community.

Die wichtigsten Erkenntnisse

Die Auswahl der passenden Datenmodellierungstechnik ist ein entscheidender Faktor für ein leistungsfähiges Data Warehouse. Mit diesen Best Practices finden Sie eine Methode, die zu Ihren Geschäftsanforderungen und Daten passt und langfristigen Mehrwert bietet. Durch den Einsatz von Automatisierungstools wie AnalyticsCreator steigern Sie zusätzlich die Geschwindigkeit, Agilität und Flexibilität Ihres Data Warehouses.

FAQs

Warum ist die Auswahl einer Datenmodellierungstechnik so wichtig?

Weil sie die Struktur, Qualität und Performance Ihres Data Warehouses maßgeblich beeinflusst.

Welche Faktoren sollte ich bei der Entscheidung berücksichtigen?

Geschäftsanforderungen, Datenquellen, Werkzeuge, Skalierbarkeit, Integrationsanforderungen, Teamfähigkeiten und Wartungskosten.

Welche Modellierungstechniken gibt es?

Häufig genutzt werden Kimball, Inmon, Data Vault 2.0, Anchor Modeling sowie hybride Ansätze.

Was passiert, wenn ich die falsche Modellierungstechnik wähle?

Es drohen schlechte Performance, komplizierte Wartung, unflexible Modelle und hohe Folgekosten.

Wie wichtig sind Datenquellen bei der Modellwahl?

Sehr wichtig – Qualität, Struktur und Komplexität bestimmen, welche Technik geeignet ist.